hdfs文件存储机制

- 文件写入: 同样地,可以使用FileSystem API将数据写入HDFS。可以使用OutputStream将数据写入到HDFS的文件中。

- 文件读取: 使用FileSystem API可以轻松地从HDFS中读取文件。可以使用FileSystem的open()方法打开一个文件,并使用InputStream读取文件内容。

- 文件操作: Hadoop提供了一系列命令行工具,如hadoop fs,用于执行文件系统操作,如创建目录、复制文件等。

}

e.printStackTrace();

以下是一个简单的Java程序,演示了如何使用Hadoop的FileSystem API读取HDFS中的文件:

通过本文的介绍,我们深入了解了HDFS存储编程的基础知识、实践经验和最佳实践。掌握了HDFS存储编程,可以更加高效地处理大规模数据,并发挥Hadoop生态系统的强大功能。

public static void main(String[] args) {

String uri = "hdfs://localhost:9000/user/input/file.txt";

import java.io.IOException;

IOUtils.copyBytes(in, System.out, 4096, false);

public class HDFSReadExample {

InputStream in = null;

import org.apache.hadoop.conf.Configuration;

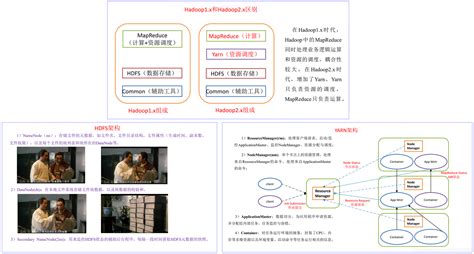

HDFS是一个分布式文件系统,它将数据存储在集群中的多个节点上,每个文件被切分成多个数据块并分布在不同的节点上。这种分布式存储方式使得HDFS能够处理大规模数据,并提供高容错性。

```java

try {

in = fs.open(new Path(uri));

import org.apache.hadoop.fs.*;

}

IOUtils.closeStream(in);

FileSystem fs = FileSystem.get(URI.create(uri), conf);

在大数据领域,HDFS(Hadoop分布式文件系统)是一个重要的组件,它被设计用来存储大规模数据集,并提供高可靠性、高吞吐量和容错性。编程与HDFS交互是进行大数据处理的关键之一,下面将深入探讨HDFS存储编程。

要与HDFS进行编程交互,通常可以使用Java API或者Hadoop命令行工具。以下是一些基本操作:

上面的示例代码使用了Hadoop的FileSystem API从HDFS中读取文件,并将文件内容输出到控制台。

try {

```

} finally {

}

} catch (IOException e) {

在进行HDFS存储编程时,有几个最佳实践需要注意:

Configuration conf = new Configuration();

深入了解HDFS存储编程

import java.io.InputStream;

}

本文 新鼎系統网 原创,转载保留链接!网址:https://acs-product.com/post/21079.html

免责声明:本网站部分内容由用户自行上传,若侵犯了您的权益,请联系我们处理,谢谢!联系QQ:2760375052 版权所有:新鼎系統网沪ICP备2023024866号-15